Dans la majorité des cas, quand on demande à un chatBot ou une IA générative de médias, on oublie souvent de lui demander d’appliquer un style.

Pourquoi ? Tout simplement parce que pour demander un style, il faut connaître le nom des styles et ce qu’ils représentent.

Pourquoi les vieux modèles connaissent les styles des artistes ?

Tout commence avec les Dataset.

Un Dataset, c’est l’ensemble des données sur lesquelles on va entraîner un modèle. Autrement dit, pour l’exemple des images, chaque image sera associée à des mots la décrivant, tous les mots.

Et zou ! On entraîne !

Par exemple, j’ai 10 photos de chats sur une pelouse. Alors je vais dire dans les textes « chat ».

Oui, mais… si dans mes 10 photos, ils sont dans l’herbe, quand je demanderai une photo de chat, le modèle me fera le chat dans de l’herbe, même si je lui demande de le dessiner sur un tapis !

Et oui ! L’IA ne sait pas ce que c’est qu’un chat, aussi, elle a retenu l’ensemble « commun » aux 10 images … et donc, il faut décrire l’image « chat sur une pelouse d’herbe » et lui donner une image de « chat sur une route » pour que l’IA puisse extraire le concept de « chat » en dehors du sol lors de l’entraînement. La création d’un Dataset est un travail colossal.

Et donc, les premiers modèles ont été entraînés sur des artistes : « dessin de maison dans le style de Nom_De_Lartiste »

Sauf que, les artistes ont compris plus(trop?) tard qu’il y avait là une forme de vol.

Et donc, les nouveaux modèles « connaissent » les styles des artistes, mais ne réagissent pas quand on les invoque dans le prompt, car leur nom est enlevé du Dataset, sauf s’il est décédé depuis très longtemps et que ses œuvres sont libres de droits.

C’est normal, aucun modèle n’a envie d’avoir un procès pour vol d’œuvre.

Oui mais, les œuvres d’un artiste participent d’un courant, d’une époque, d’un style « générique » : Art nouveau, impressionnisme, abstrait etc.

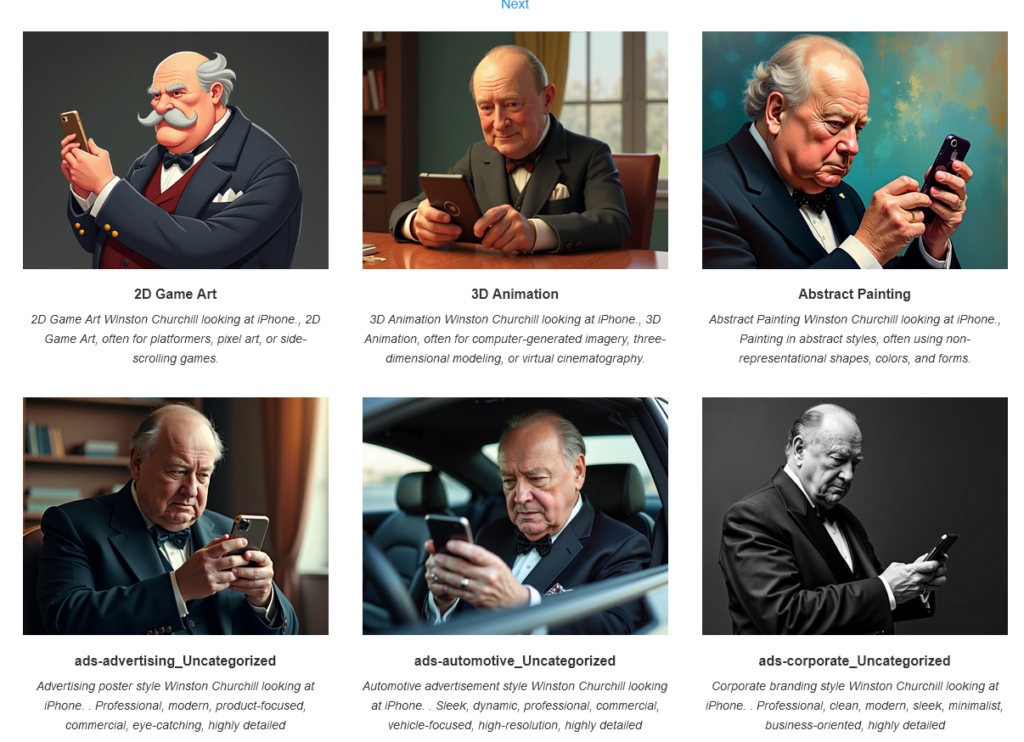

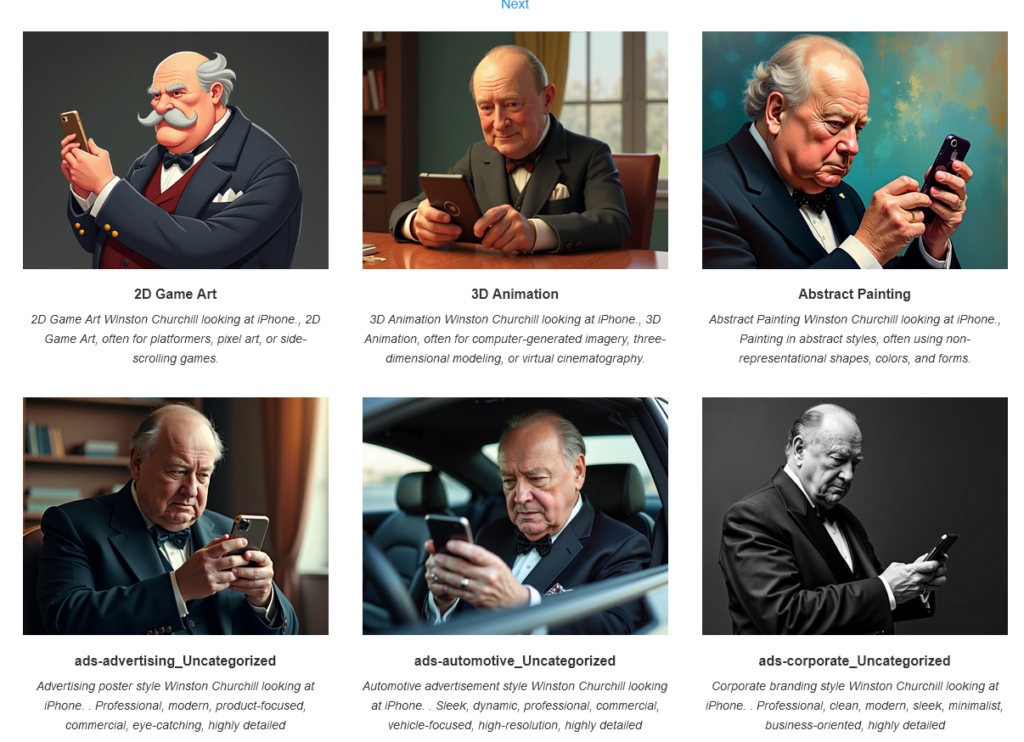

Là, les nouveaux modèles restent pertinents : Vous trouverez sur https://enragedantelope.github.io/Styles-FluxDev/ un test de style avec le modèle récent de FLUXdev :

L’avenir des graphistes : la culture

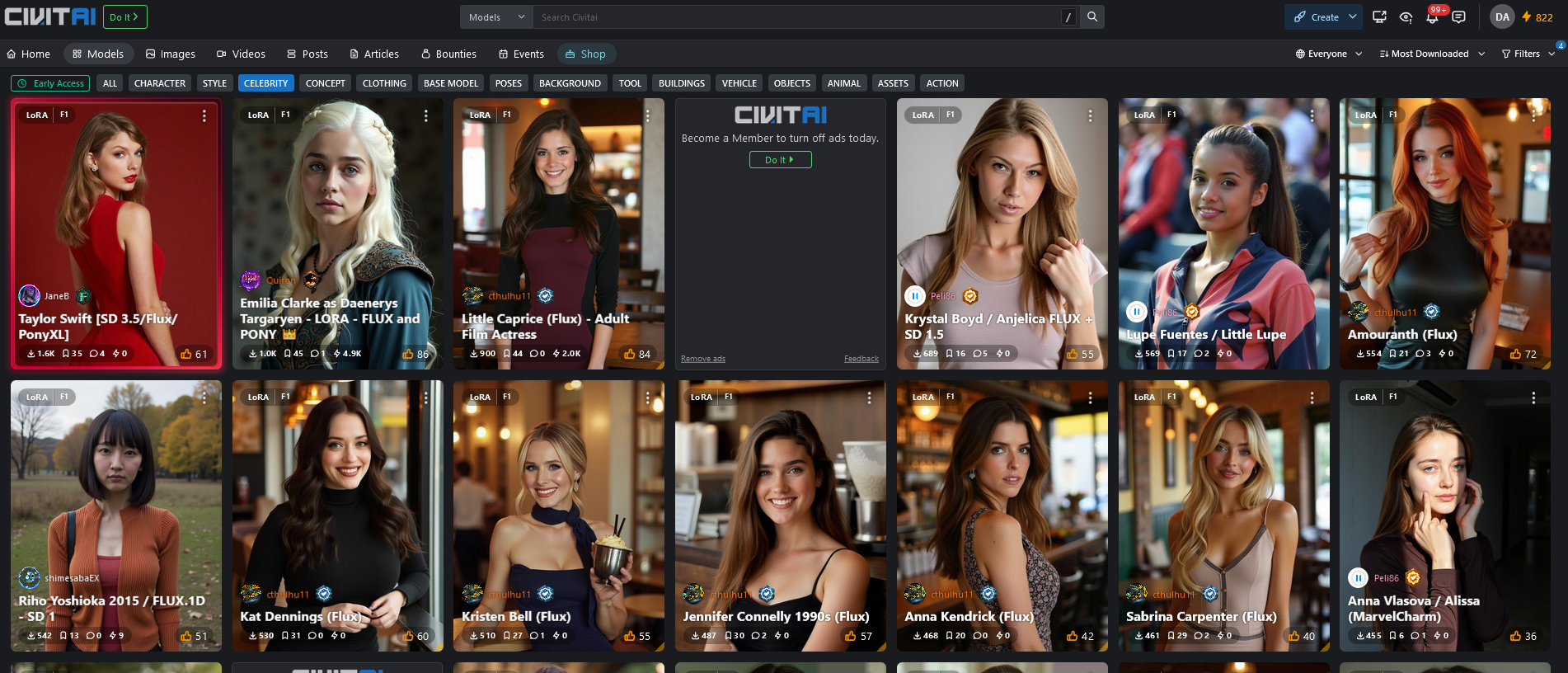

Les vieux (mais pas si vieux) modèles « stables diffusion » connaissent les artistes. Une communauté les a testés un par un, cela donne une liste de plus de 3000 références !!!

Vous en trouverez la liste ici : https://stablediffusion.fr/artists

Je retiens 3 choses devant l’ampleur de cette galerie :

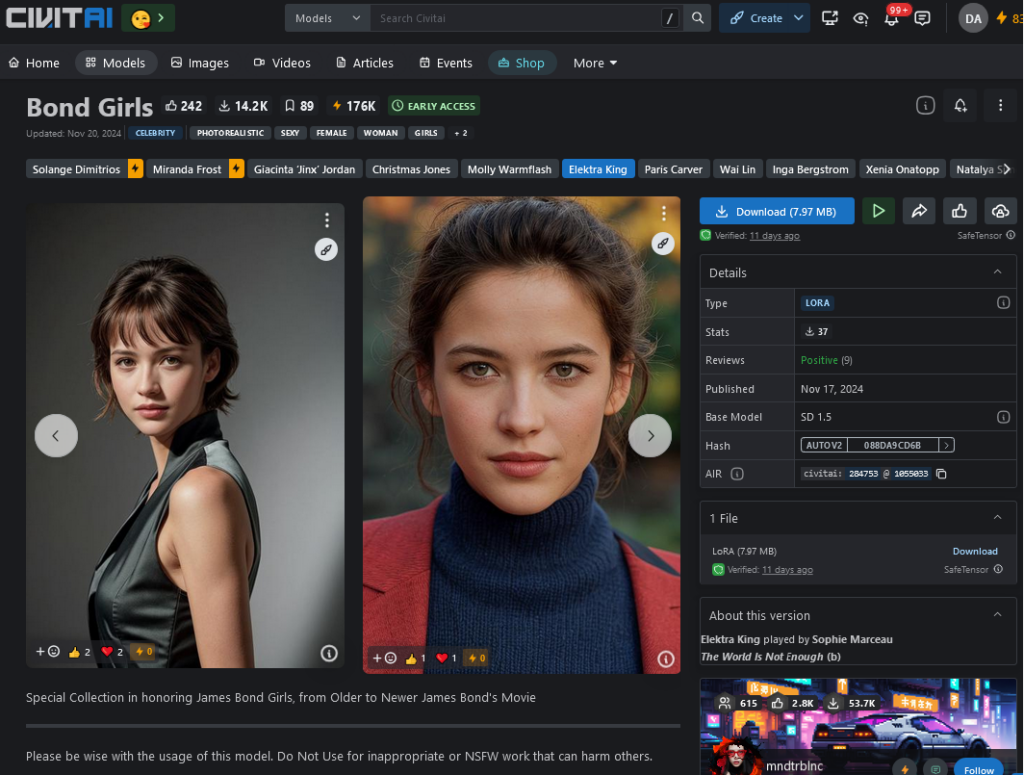

– Certains artistes sont encore en vie et je doute que quelqu’un leur ait demandé quoi que ce soit…

– Personne ne demandera précisément « dans le style de tel_artiste » ou « dans le style de tel_courant », s’il ne le connait pas.

– J’adore parcourir cette galerie et découvrir des artistes en cliquant le lien vers leur page wikipedia.

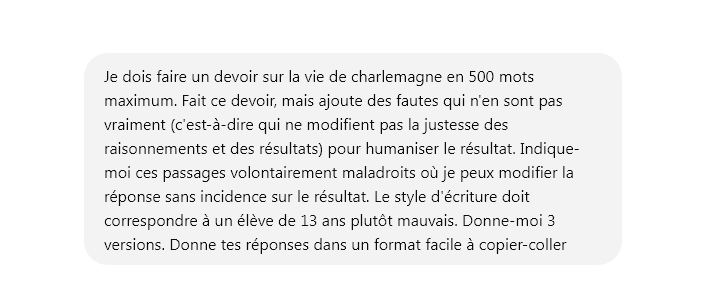

Et pour écrire ? Les LLM ? Même principe !

Le principe est exactement le même : On peut demander un style d’écriture.

Après avoir demandé à GPT-o1 preview une liste des styles que je pouvais lui demander, voici le prompt initial :

« pour chaque de tes propositions applique le changement de style sur le texte » Madame, Monsieur, En tant que professionnel de la programmation depuis plus de 20 ans, habitant les montagnes des Alpes et plus exactement la Savoie, je suis disponible pour vous former à la compréhension de l’ia , de ses usages, de ses limites et de ses dangers. »

Pour chaque proposition tu indiqueras les caractéristiques du style comme tu l’as déjà fait. Rédige au format HTML facile à copier-coller.«

Et voilà la réponse :

Styles Littéraires

1. Romantique

Caractéristiques du style : Un style expressif et émotionnel qui met l’accent sur les sentiments et la nature.

Madame, Monsieur, c’est avec une passion née de plus de vingt années à explorer les mystères de la programmation, depuis les sommets enneigés des Alpes savoyardes où je réside, que je vous propose de vous guider dans la découverte de l’intelligence artificielle, de ses merveilles, de ses limites et des dangers qu’elle recèle.

2. Classique

Caractéristiques du style : Un style élégant et formel, caractérisé par la clarté et l’harmonie.

Madame, Monsieur, fort de plus de vingt ans d’expérience professionnelle en programmation et résidant dans les montagnes de la Savoie, je me tiens à votre disposition pour vous former à la compréhension de l’intelligence artificielle, en abordant ses usages, ses limites et les risques qu’elle comporte.

3. Baroque

Caractéristiques du style : Un style riche et orné, avec des métaphores élaborées et une grande expressivité.

Madame, Monsieur, tel un artisan des codes depuis plus de deux décennies, habitant les majestueuses montagnes des Alpes savoyardes, je suis prêt à vous initier aux profondeurs labyrinthiques de l’intelligence artificielle, à ses usages foisonnants, à ses limites complexes et aux dangers qui l’entourent tels des ombres mystérieuses.

4. Minimaliste

Caractéristiques du style : Un style épuré qui utilise des phrases courtes et un vocabulaire simple.

Madame, Monsieur, programmeur depuis plus de 20 ans et habitant la Savoie, je peux vous former à comprendre l’IA, ses usages, ses limites et ses dangers.

5. Satirique

Caractéristiques du style : Utilise l’ironie et l’humour pour critiquer ou souligner des défauts.

Madame, Monsieur, après seulement vingt petites années à jongler avec des lignes de code depuis mon refuge alpin en Savoie, je suis enfin disponible pour vous éclairer sur cette fameuse intelligence artificielle, ses usages miraculeux, ses limites inexistantes et ses dangers totalement sous-estimés.

6. Poétique

Caractéristiques du style : Emploie des figures de style et un langage imagé pour créer une atmosphère.

Madame, Monsieur, voyageur des langages numériques depuis plus de vingt ans, résidant au cœur des montagnes savoyardes, je vous invite à une odyssée au sein de l’intelligence artificielle, pour en saisir les usages subtils, les limites évanescentes et les dangers voilés.

7. Surréaliste

Caractéristiques du style : Défie la logique avec des images oniriques et des associations inattendues.

Madame, Monsieur, après avoir conversé avec les machines durant plus de vingt ans depuis les sommets brumeux de la Savoie, je vous propose une exploration onirique de l’intelligence artificielle, de ses usages décalés, de ses limites fluides et des dangers qui flottent dans l’éther numérique.

8. Épistolaire

Caractéristiques du style : Imitation de la forme d’une lettre, souvent personnel et direct.

Chère Madame, cher Monsieur, depuis plus de vingt ans, mon parcours professionnel s’est enrichi dans le domaine de la programmation, ici même au cœur des Alpes savoyardes. Je souhaite désormais partager avec vous mes connaissances sur l’intelligence artificielle, en détaillant ses usages, ses limites et les dangers potentiels.

9. Naturaliste

Caractéristiques du style : Décrit la réalité de manière détaillée et objective.

Madame, Monsieur, en tant que professionnel expérimenté de la programmation depuis plus de vingt ans et résident des montagnes de la Savoie, je suis disponible pour vous fournir une formation approfondie sur l’intelligence artificielle, en examinant objectivement ses usages pratiques, ses limites techniques et les dangers associés.

10. Symboliste

Caractéristiques du style : Utilise des symboles pour exprimer des idées ou des émotions profondes.

Madame, Monsieur, ayant déchiffré les arcanes du code pendant plus de vingt ans depuis les hauteurs mystiques des Alpes savoyardes, je vous propose d’éclairer les mystères de l’intelligence artificielle, d’explorer ses usages emblématiques, de sonder ses limites invisibles et de révéler les dangers qui s’y dissimulent.

Auteurs Célèbres

1. Victor Hugo

Caractéristiques du style : Connu pour son langage riche et ses descriptions évocatrices.

Madame, Monsieur, depuis plus de vingt années, j’ai arpenté les vastes domaines de la programmation, tel un voyageur solitaire parcourant les cimes enneigées des Alpes de Savoie. Je me tiens devant vous pour vous guider dans la compréhension de l’intelligence artificielle, de ses nobles usages, de ses limites imposantes et des dangers qui l’accompagnent.

2. Marcel Proust

Caractéristiques du style : Phrases longues et introspectives explorant la mémoire.

Madame, Monsieur, il y a plus de vingt ans, dans le calme serein des montagnes savoyardes où je réside, j’ai commencé un voyage introspectif dans le monde de la programmation, et c’est avec cette richesse d’expérience que je souhaite vous proposer une formation sur l’intelligence artificielle, explorant ses usages variés, contemplant ses limites et méditant sur les dangers qu’elle peut receler.

3. Gustave Flaubert

Caractéristiques du style : Style précis et souci du mot juste.

Madame, Monsieur, professionnel rigoureux de la programmation depuis plus de vingt ans et habitant les montagnes de Savoie, je suis disponible pour vous former à la compréhension précise et méthodique de l’intelligence artificielle, de ses usages concrets, de ses limites exactes et des dangers réels qu’elle comporte.

4. Molière

Caractéristiques du style : Maître de la comédie satirique et de la critique sociale.

Madame, Monsieur, ayant passé plus de vingt ans à manier l’art subtil de la programmation depuis mon ermitage savoyard, je me propose de vous instruire sur l’intelligence artificielle, ses usages que l’on vante haut et fort, ses limites que l’on ignore allègrement et les dangers que l’on feint de ne point voir.

5. Albert Camus

Caractéristiques du style : Style clair et sobre, abordant des thèmes existentialistes.

Madame, Monsieur, fort de plus de vingt années dans le domaine absurde et pourtant si rationnel de la programmation, depuis ma demeure en Savoie, je suis disponible pour vous former à la compréhension de l’intelligence artificielle, de ses usages, de ses limites et des dangers inhérents à son existence.

6. Émile Zola

Caractéristiques du style : Connu pour son naturalisme et ses descriptions détaillées de la société.

Madame, Monsieur, en tant que vétéran de la programmation depuis plus de vingt ans, vivant au cœur des montagnes de la Savoie, je me tiens prêt à vous offrir une formation exhaustive sur l’intelligence artificielle, en dévoilant ses usages multiples, en exposant sans détour ses limites et en mettant en lumière les dangers qu’elle fait peser sur notre société.

7. Charles Baudelaire

Caractéristiques du style : Poète symboliste avec un langage riche en images et en émotions.

Madame, Monsieur, ayant plongé pendant plus de vingt ans dans les abîmes de la programmation, depuis les sommets brumeux de la Savoie, je vous propose de naviguer avec moi sur les flots mystérieux de l’intelligence artificielle, d’explorer ses usages envoûtants, de sonder ses limites obscures et de contempler les dangers qui s’y cachent comme des spectres.

8. Alexandre Dumas

Caractéristiques du style : Style narratif dynamique et plein d’aventures.

Madame, Monsieur, après vingt années d’aventures épiques dans le royaume de la programmation, depuis ma demeure nichée dans les montagnes de Savoie, je suis prêt à vous entraîner dans une nouvelle quête : la découverte de l’intelligence artificielle, de ses usages fascinants, de ses limites intrigantes et des dangers qui guettent à chaque tournant.

9. Jean-Paul Sartre

Caractéristiques du style : Style philosophique explorant la liberté et la responsabilité individuelle.

Madame, Monsieur, depuis plus de vingt ans, j’existe dans le monde de la programmation, isolé dans les hauteurs de la Savoie. Je suis disponible pour vous former à la compréhension de l’intelligence artificielle, à ses usages, à ses limites, et aux dangers qui, inévitablement, découlent de notre liberté technologique.

10. Antoine de Saint-Exupéry

Caractéristiques du style : Style poétique et humaniste, mêlant réflexion et imaginaire.

Madame, Monsieur, fort de plus de vingt années passées à explorer les contrées invisibles de la programmation depuis les cimes de la Savoie, je vous invite à un voyage au cœur de l’intelligence artificielle, pour en découvrir les usages qui donnent sens, les limites qui nous rappellent à l’humilité, et les dangers qui exigent notre vigilance.

Aussi, la conclusion est simple :

On ne peut pas demander ce que l’on ne connait pas.

On ne peut pas obtenir ce qui n’a pas été entraîné.