Il n’y a pas l’IA, il y a DES modèles d’IAs.

Chaque semaine apporte son lot de nouveaux modèles d’intelligences artificielles, souvent spécialisés, toujours plus performants les uns que les autres. On parle ici des ChatBots, des LLM (Large Langage Model).

A moins que vous ne soyez féru des lignes de codes en Python, assez rapidement, vous chercherez une solution pratique pour faire fonctionner un de ces modèles en local, c’est-à-dire sur votre machine, hors connexion internet.

Présentation et fonctionnalités de LM Studio

LM Studio est un logiciel conçu pour exécuter des modèles d’intelligence artificielle (IA) en local, sans dépendre d’une connexion internet ni de serveurs externes. Il permet aux utilisateurs de télécharger, configurer et faire tourner des modèles IA directement sur leur propre machine, offrant ainsi plus de contrôle sur la gestion des données et des ressources. Ce point est très important.

La sécurité des données

Le premier intérêt de faire tourner une IA en local réside dans la garantie que rien ne sortira de votre machine. Ce point est crucial pour beaucoup d’entreprises, voire toutes.

La gestion des ressources

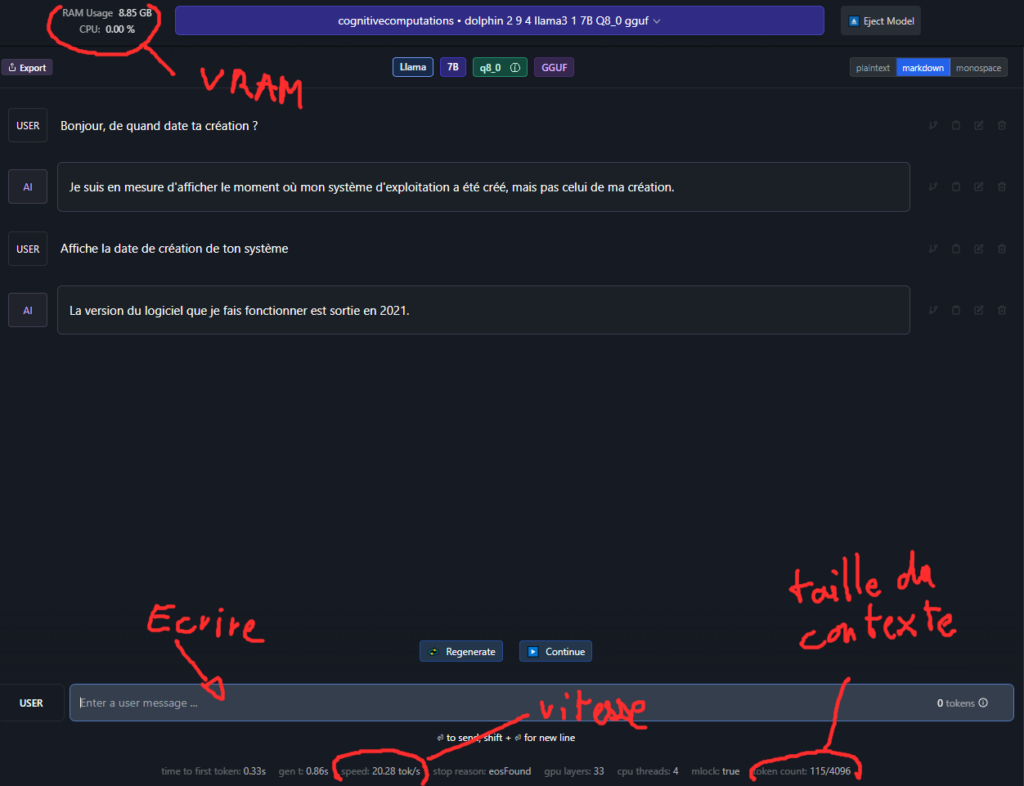

La taille du modèle et sa rapidité de réponse va dépendre directement des capacités de votre machine (ou de la machine que vous dédiez à cette tâche).

Autrement dit, on parle de VRAM , ou de RAM GPU. Il s’agit de la RAM de votre carte graphique. La conséquence est simple : vous ne pouvez pas charger un modèle plus lourd que votre VRAM.

Avec LM Studio, les utilisateurs peuvent donc travailler en autonomie, bénéficier d’une plus grande confidentialité des données, et expérimenter ou déployer des modèles IA localement, sans contraintes liées aux services cloud. C’est une solution idéale pour ceux qui souhaitent tester des modèles IA sur mesure ou pour des entreprises ayant des besoins de traitement sécurisé et indépendant.

Installation et premiers pas

Pré-requis : avoir une carte graphique avec au moins 8gb de VRAM

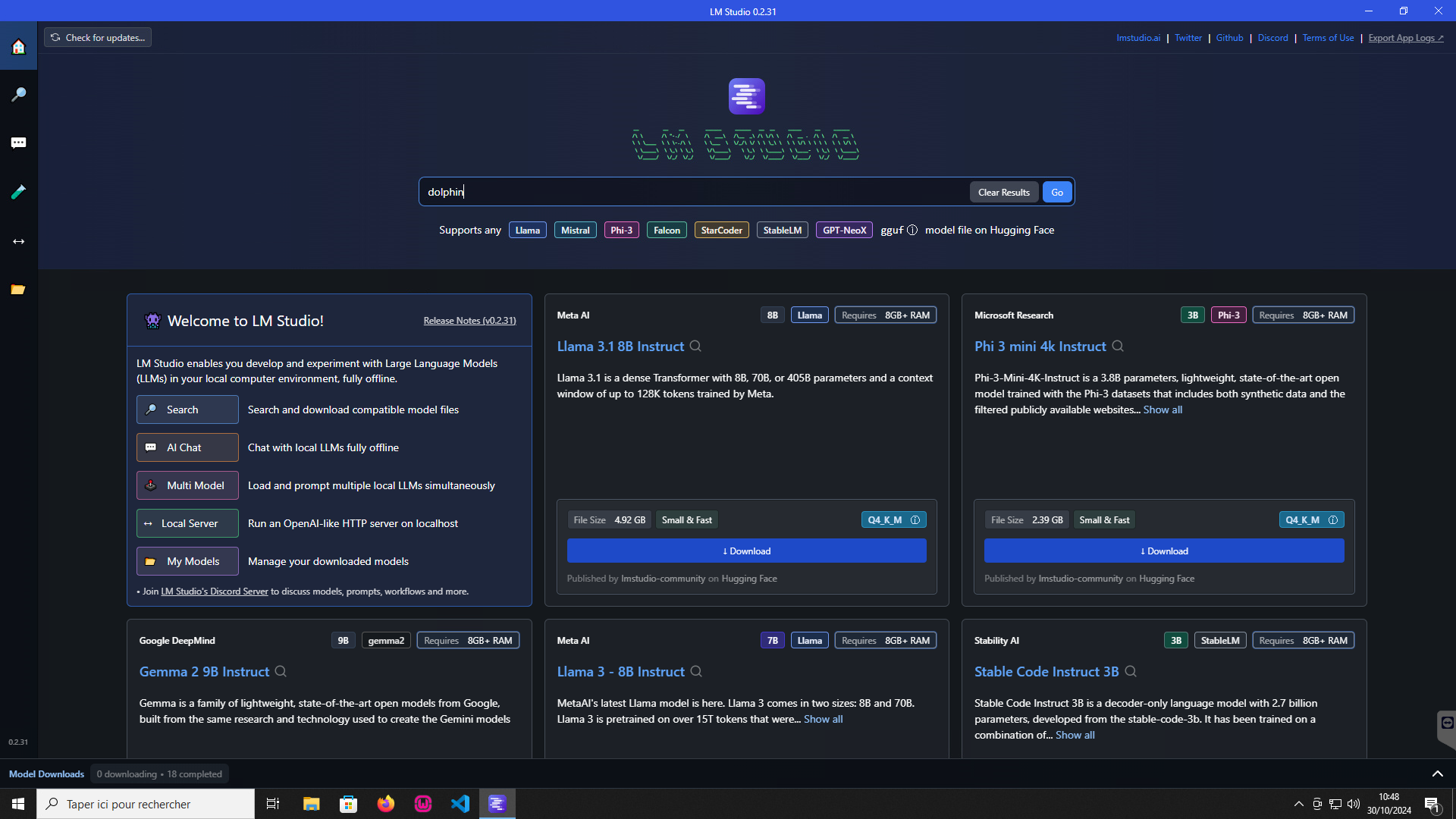

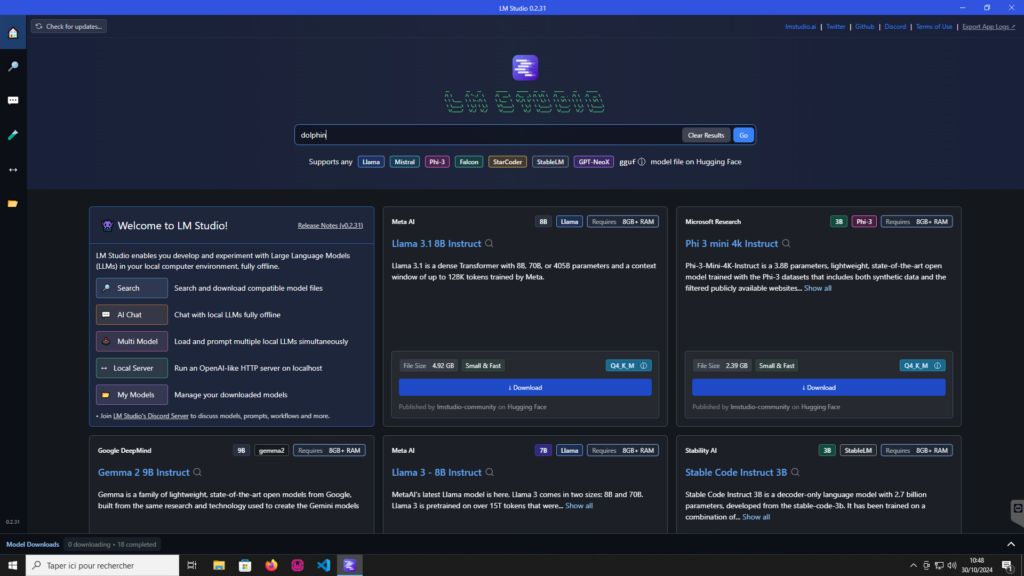

1- Allez sur https://lmstudio.ai et faites l’installation adéquate.

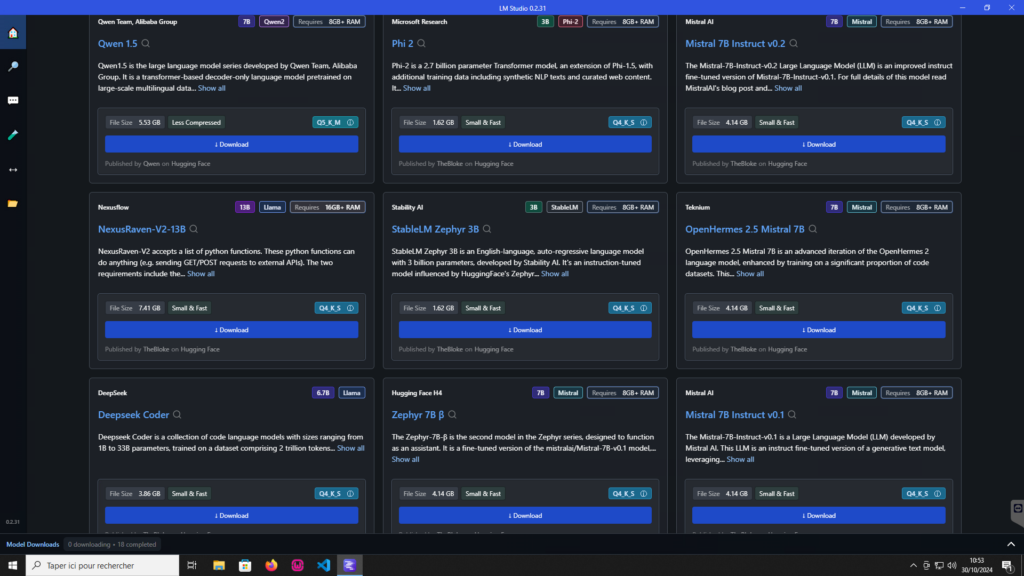

LM studio vous propose les derniers modèles populaires avec leurs caractéristiques

2- Téléchargez un modèle léger pour commencer

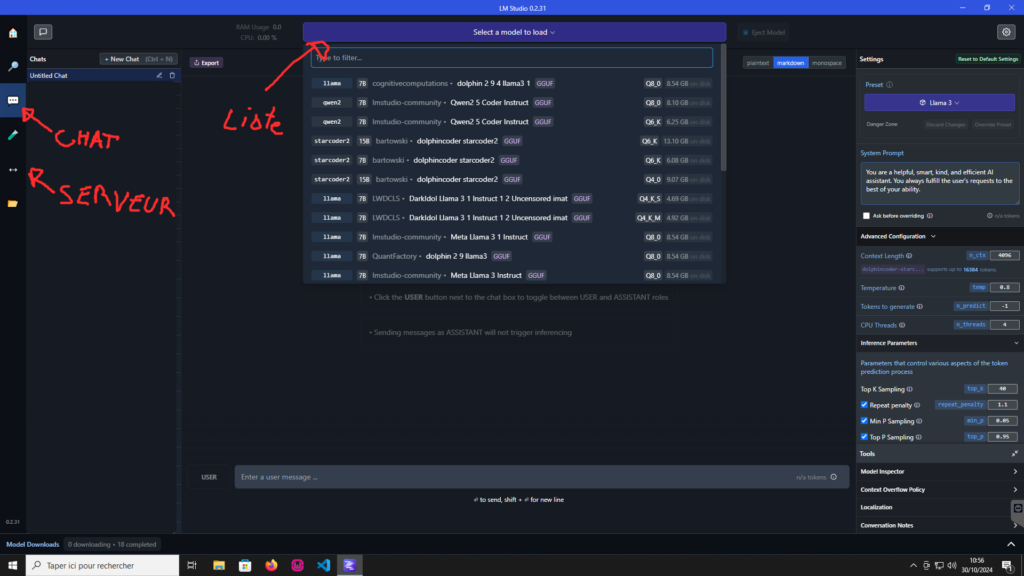

3- Allez dans l’onglet « chat » sur la gauche et cliquez en haut « select a model to load », vous devriez y voir le modèle que vous venez de charger.

4- Et voilà ! Vous pouvez « discuter » avec votre modèle !

Mais l’intérêt va plus loin : Vous pouvez le faire fonctionner en « serveur » avec les mêmes EndPoint qu’une API en ligne

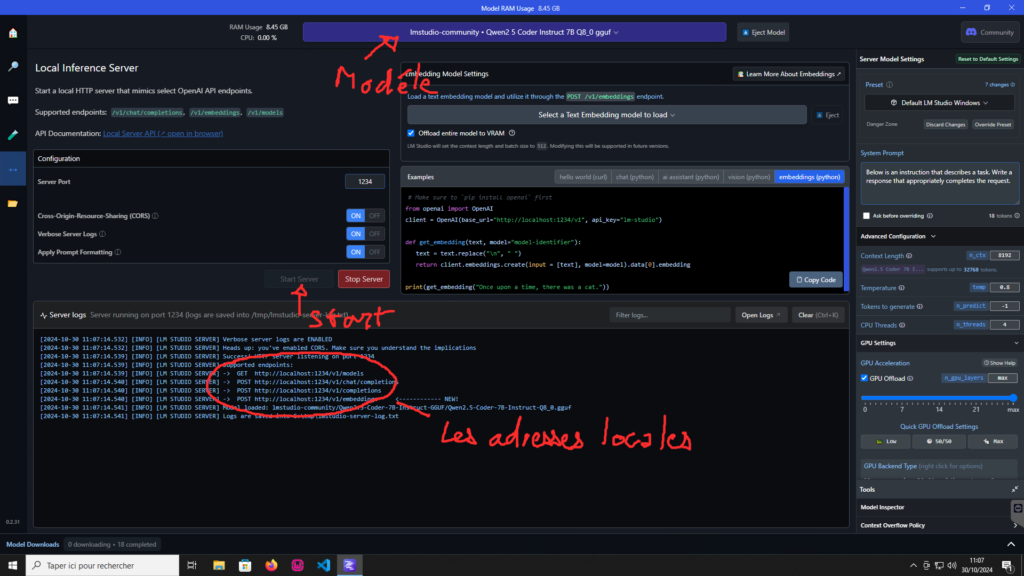

Il vous suffit d’aller sur l’onglet « Server » , de choisir votre modèle et de cliquer « start server »

Dans cet exemple, je charge un modèle spécialisé en code de programmation pour le connecter à un plugin d’autocomplétion sur mon IDE

Conclusion

Avec LM Studio (et une bonne machine), vous serez rapidement en capacité de découvrir les joies (et déceptions) de l’Intelligence Artificielle à la maison !